Aux détours d’un déjeuner d’équipe, nous avons partagé sur l’un des sujets brûlants du moment, la vague IA. Certains craignent les changements qu’elle apporte, d’autres sont subjugués par les possibilités qu’elle offre. Une chose est certaine, c’est un sujet passionnant !

Et si la majorité des membres de Mavana sont experts des questions environnementales et sociales de l’intelligence artificielle, ce n’est pas le cas de Julie (aka notre experte en bien-être numérique au travail). Elle nous a posé de nombreuses questions intéressantes. Et on s’est dit que les réponses pourraient vous intéresser également !

Cet article se veut une introduction généraliste à l’intelligence artificielle et aux impacts réels qui y sont liés. Un second article plus spécialisé suivra bien vite.

L'intelligence artificielle… kézako ?

Et si nous commencions par le début ? Néophyte en la question, qu’est-ce que Julie entend lorsque l’on parle d’“intelligence artificielle” ? Les idées qui lui viennent immédiatement, c’est que l’IA est une technologie qui permet, par exemple, de créer des plans pour son aménagement intérieur à partir d’une simple photo de sa pièce, ou encore de créer du contenu simple type mail ou résumé, à partir d’une phrase. Bref, quand Julie nous parle d’IA, elle parle en fait d’intelligence artificielle générative.

À ce stade, à moins que vous ne viviez dans une grotte depuis quelques années, vous devriez avoir quelques noms qui vous viennent en tête (du genre ChatGPT, Gemini ou DeepSeek, par exemple). Pour vous donner une idée de la pénétration de l’IA générative dans nos sociétés, ChatGPT a compté 400 millions d’utilisateurs par semaine sur le mois de février 2025. Avec la sortie de GPT-4 en mars, le phénomène s’est encore accéléré puisque 700 millions d’images ont été générées dans la première semaine, portés par les tendances “Ghibli” ou “Starter pack” notamment.

Alors, avec une telle présence de ces outils dans nos pratiques numériques, il est plutôt légitime de se demander (comme l’a fait Julie) : quels impacts l’intelligence artificielle a-t-elle sur l’environnement ?

Puisque que personne ne connaît vraiment les impacts environnementaux des systèmes d’intelligence artificielle générative (leur infrastructure sous-jacente est maintenue très opaque – à dessein – par leurs fournisseurs), cet article s’appuie sur le meilleur état de connaissance à l’heure actuelle.

IA générative… de consommation et d'émissions

Pour répondre à Julie, nous avons décidé de nous intéresser dans un premier temps à la consommation d’énergie des systèmes d’IA générative. Selon l’IEA (International Energy Association), la consommation électrique des centres de données pourrait passer de 415 TWh en 2024 à 945 TWh d’ici à 2030. Oui oui, vous avez bien lu, leur consommation pourrait plus que doubler en quelques années, portée notamment par le développement des centres de données dédiés aux systèmes d’intelligence artificielle générative. Pour vous donner un ordre d’idée, la France a consommé 445 TWh d’électricité en 2023, l’IA est donc en passe de conduire les centres de données vers une consommation électrique deux fois supérieure à celle de notre pays, rien que ça ! Forcément, Julie se demande d’où provient une telle augmentation sur une période si courte (et vous aussi j’en suis sûr !).

Il se trouve que l’IA générative consomme de l’énergie (mais genre, vraiment beaucoup !). Le modèle GPT-4o mini (le standard actuel de l’offre d’Open AI) a une consommation électrique d’environ 2 Wh pour 400 tokens, ce qui équivaut au format d’une rédaction d’un à trois paragraphes. Un montant en Wh, ce n’est pas très parlant pour Julie, donc pour imager ça, dites-vous que cela équivaut à environ 35 minutes de lumière avec une ampoule LED.

Comme son nom l’indique, GPT-4o mini est un modèle relativement petit (35 milliards de paramètres : petit mais costaud…). En comparaison, son équivalent GPT-4o présente une consommation électrique de 35 Wh pour 400 tokens, soit 11 heures d’éclairage LED.

Or, une telle consommation se traduit forcément en impact sur le réchauffement climatique, cet impact est mesuré en équivalent CO2, et ça, Julie maîtrise parfaitement à force d’entendre toute l’équipe parler de Bilans carbone. Si l’on reprend notre exemple GPT-4o mini et une requête de 400 tokens, on obtient une estimation d’émission de 1,83 g de CO2 (soit l’équivalent 3 minutes de streaming en haute qualité). Pour son grand frère GPT-4o, on passe à 21,4g de CO2, pour une requête équivalente (cela représente les émissions de 20 minutes de streaming).

Et pour un usage massif alors ?

Maintenant nous avons tous quelques ordres de grandeur en tête concernant l’impact environnemental de l’IA générative, essayons de voir ce que pourrait donner de tels impacts si l’usage de l’IA devenait global (du genre VRAIMENT global) !

Pour ce faire, nous nous appuierons sur le calculateur EcoLogits (sur lequel vous devriez faire un tour si le sujet vous intéresse) pour estimer la consommation électrique et l’impact carbone d’un usage massif des deux modèles d’OpenAI. Le calculateur extrapole alors les résultats précédents pour simuler l’usage quotidien des modèles d’IA par 1% de la population mondiale (soit 80 millions d’individus) pendant un an. Résultat ? Le modèle « mini » d’OpenAI consommerait autant d’énergie que la production annuelle de 14 éoliennes. En termes d’émissions de gaz à effet de serre, ce n’est pas franchement mieux puisque cela équivaudrait à 209 vols aller-retour Paris-New York.

Si vous trouvez que ces résultats sont déjà impressionnants, attendez de découvrir l’impact du modèle GPT-4o dans les mêmes conditions : avec un tel modèle, la consommation énergétique est équivalente à la production annuelle de 244 éoliennes et les émissions de gaz à effet de serre correspondent cette fois à 3535 vols aller-retour Paris-New York.

IA'ssoiffée

L’intelligence artificielle générative consomme aussi de l’eau, et même beaucoup d’eau, or pour Mavana, c’est une ressource précieuse (au point que notre siège social se trouve dans un moulin… à eau) !

Cette consommation vient en grande partie des besoins en eau des centres de données pour leurs systèmes de refroidissement et dépend donc en grande partie de la localisation de ces derniers et de leur fonctionnement.

Ainsi, mesurer l’impact en eau des systèmes d’IA générative est complexe, dans un article paru en 2023, Shaolei Ren et ses collègues estiment la consommation d’une requête de 100 mots sur ChatGPT à environ 500 ml d’eau. Si l’on reprend notre exemple, pour 400 tokens (la rédaction d’un texte d’environ 305 mots), cela représenterait environ 1,5 L d’eau.

Néanmoins, ces chiffres étaient estimés à partir du modèle GPT-3 et des centres de données américains. Nous pouvons alors supposer que la différence de taille entre le modèle GPT-3 et GPT-4o (de 175 milliards de paramètres à 1,8 trillion de paramètres) et l’augmentation de la consommation électrique qui l’accompagne, entraînent une hausse conjointe de la consommation en eau de chaque requête. D’autant plus que cette quantité d’eau ne concerne que celle évaporée pour le refroidissement des serveurs pour la requête, et ne prend pas en compte l’intégralité de l’eau prélevée nécessaire au système. Dans ce même article, les chercheurs américains ont estimé l’empreinte hydrique globale de l’IA en 2027 : au total, entre 4,2 et 6,6 millions de m³ d’eau prélevée par l’IA. Pour permettre à Julie (et à nos lecteurs) de mieux saisir l’enjeu, cela représente 4 à 6 fois le prélèvement en eau annuel du Danemark.

Et ensuite ?

Face à toutes ces réflexions, il semblerait naturel de se pencher sur les gains en efficience n’est-ce-pas ?

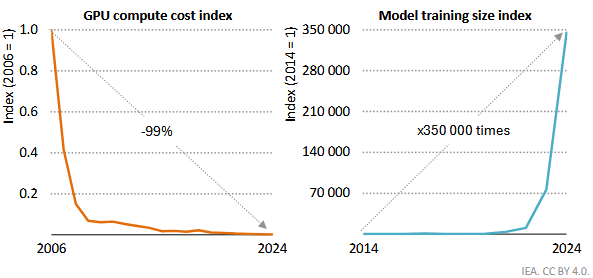

Essayons de voir ce qu’il en est ! Des gains en efficience, il y en a, et ce depuis bien longtemps. La gravure des puces est par exemple de plus en plus fine et la consommation énergétique unitaire de ces dernières est de plus en plus faible. Mais cela entraîne ce que l’on appelle un « effet rebond« , c’est-à-dire que les gains attendus liés à la baisse de la consommation des puces sont largement compensés, voire dépassés, par l’augmentation de la taille des modèles permise par la baisse conjointe de la consommation d’énergie, et du coût des calculs.

Nous nous retrouvons donc dans ce que nos amis économistes appellent le « Paradoxe de Jevons » (oui, c’est un de ces messieurs du 19e siècle qui portaient la barbe et qui réfléchissaient beaucoup). Or une telle situation laisse penser que la solution ne sera pas (ou de façon marginale) technique, et qu’il appartient aux utilisateurs d’adopter un usage responsable de ces technologies. En comparaison, une recherche sur un moteur de recherche consomme environ 10 fois moins d’énergie qu’une requête via ChatGPT. Ainsi, il s’agit de cadrer nos usages de l’IA générative à des fins pertinentes et aussi limitées que possible.

Les entreprises peuvent également être amenées à repenser leur usage de l’IA générative dans une perspective plus soutenable. Dans ce cadre, les chatbots faisant office de service clients peuvent être substitués par une “foire aux questions” ou une page “aide” bien construite, permettant la recherche en langage naturelle, pour un impact bien moindre. À ce titre, bien d’autres usages des IA générative pourrait être questionnés, comme l’aide à la programmation par langage naturel ou la création de contenu.

Avec tout ça, Julie est au point au sujet de l’impact environnemental de l’IA et nous espérons que cet article vous aura également apporté quelques éclaircissements. S’il vous reste la moindre question, surtout n’hésitez pas à nous contacter. Julie se fera Les experts de Mavana se feront un plaisir d’en parler avec vous !

Clément Camps

Chargé de recherches | Adoption et mise en œuvre

sociotechnique des stratégies

Pour aller plus loin :

Un peu de lecture

https://www.comparia.beta.gouv.fr/

https://huggingface.co/spaces/genai-impact/ecologits-calculator#5614461f

Un peu de sensibilisation

Nos experts se feront un plaisir de sensibiliser vos équipes aux impacts environnementaux de l’intelligence artificielle (au sein de votre entreprise ou sur le lieu de votre séminaire, en Occitanie).

Des conférences personnalisées, ainsi que des ateliers ludiques pour apprendre les ordres de grandeurs autours de l’IA ou connaître les bonnes pratiques pour une IA frugale ont été créés par Mavana.

Gillo Malpart

Expert en numérique responsable et durable

Fabienne Lefèvre

Chargée de missions en évaluation environnementale